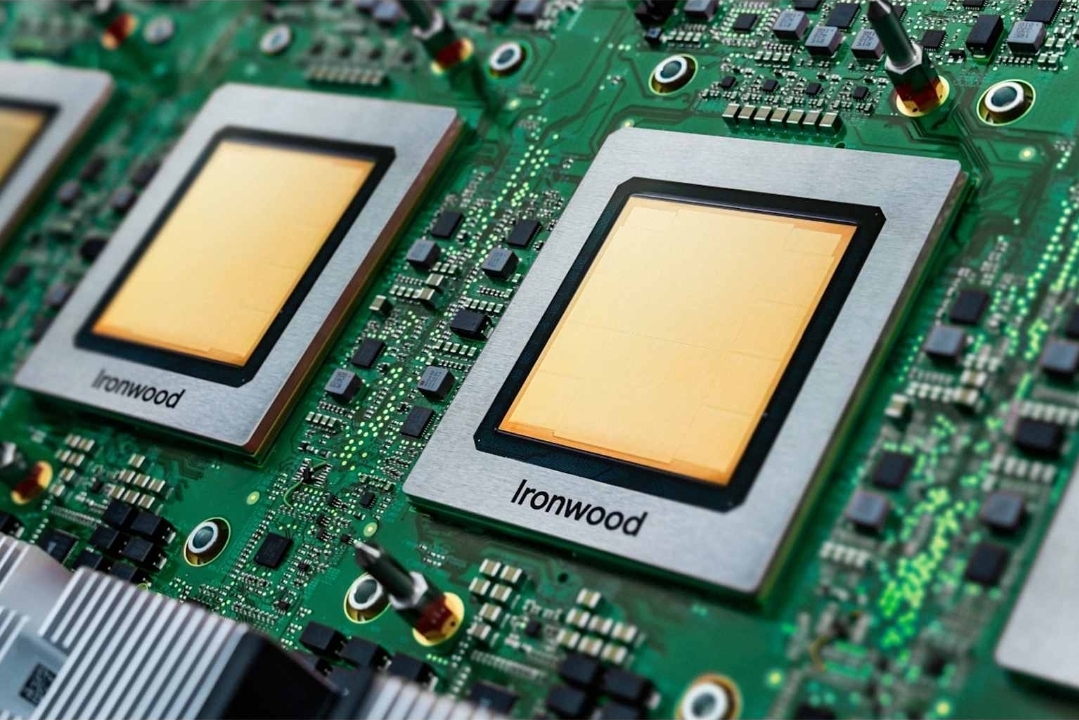

AI 반도체 시장의 중심에 서 있는 엔비디아에 도전장을 내민 구글이 7세대 텐서 처리 장치인 TPU Ironwood(아이언우드)를 공개했습니다. 2025년 4월 9일 구글 클라우드 넥스트 컨퍼런스에서 공개된 이번 발표는 신제품 출시를 넘어, 클라우드 생태계의 판도를 바꾸려는 전략적 시도로 평가받습니다. 구글이 직접 AI 칩을 설계하고 서비스에 적용하면서, 엔비디아 중심의 인공지능 하드웨어 시장이 근본적으로 재편될 가능성이 커지고 있습니다.

아이언우드 TPU의 핵심 성능과 기술적 진화

구글이 새롭게 선보인 TPU Ironwood는 '추론(inference)의 시대'를 위해 특별히 설계된 최초의 TPU입니다. 구글은 이를 "AI 발전의 패러다임 전환"이라고 설명하며, 실시간 정보를 제공하는 반응형 AI에서 통찰과 해석을 능동적으로 생성하는 AI로의 전환을 의미한다고 밝혔습니다.

Ironwood는 4,614 FP8 테라플롭스의 연산 성능을 갖추고 있으며, 192GB의 HBM3E 메모리를 탑재해 7.37TB/s의 대역폭을 확보했습니다. 이 메모리 용량은 전 세대인 Trillium(TPU v6e)의 6배에 달하며, 더 큰 모델과 데이터셋을 처리할 수 있어 빈번한 데이터 전송 필요성을 줄이고 성능을 향상시킵니다.

Ironwood는 하나의 시스템 포드에서 256개 또는 9,216개의 칩으로 확장 가능하며, 9,216개 칩 구성의 경우 총 42.5 FP8 엑사플롭스의 컴퓨팅 파워를 구현할 수 있습니다. 구글은 이를 세계 최대 슈퍼컴퓨터인 엘 카피탄(El Capitan)의 1.7 엑사플롭스보다 24배 더 높은 성능이라고 설명했습니다. 다만 이 비교는 Ironwood가 FP8 정밀도를, 엘 카피탄은 FP64 정밀도를 사용한 것으로, 동일한 정밀도로 환산하면 수치가 달라질 수 있습니다.

에너지 효율 측면에서도 주목할 만합니다. Ironwood는 Trillium 대비 2배의 성능당 전력 효율을 제공하며, 2018년 첫 클라우드 TPU보다 거의 30배나 더 전력 효율적입니다. 9,216개 칩 포드는 최대 부하에서 약 10메가와트를 소비하는 것으로 추정되며, 칩당 TDP는 700W에서 1kW 사이로 추정됩니다. 구글의 고급 액체 냉각 솔루션과 최적화된 칩 설계는 연속적이고 무거운 AI 워크로드에서도 표준 공랭식의 최대 2배 성능을 안정적으로 유지할 수 있습니다.

Ironwood의 가장 큰 의미는 클라우드 서비스와의 긴밀한 통합성입니다. 구글 클라우드 플랫폼(GCP)을 통해 고객들이 곧바로 Ironwood 기반의 AI 인프라를 활용할 수 있게 되면서, 개발자와 기업 입장에서는 별도의 GPU 세팅 없이도 초고속 모델 학습이 가능해집니다. 이는 곧 AI 개발의 민주화를 촉진하는 효과로 이어집니다.

구글의 전략, '탈엔비디아'와 생태계 확장

2025년 11월 6일, 구글은 Ironwood가 수주 내에 일반 사용자에게 공개될 것이라고 발표했습니다. 이는 4월에 테스트 및 배포용으로 처음 소개된 이후 7개월 만의 정식 출시입니다. Ironwood의 등장은 구글이 엔비디아 중심의 생태계에서 독립을 선언한 신호탄으로 해석됩니다.

주요 고객들이 이미 줄을 서고 있습니다. AI 스타트업 Anthropic은 Claude 모델을 실행하기 위해 최대 100만 개의 새로운 TPU를 사용할 계획이라고 구글은 밝혔습니다. Lightricks는 LTX-2 멀티모달 시스템을 훈련하고 서비스하기 위해 Ironwood 활용을 시작했습니다. TrendForce에 따르면 구글은 Ironwood에 대해 Broadcom과 파트너십을 맺고 있으며, 2026년 확장될 예정입니다. TrendForce는 구글의 TPU 출하량이 클라우드 서비스 제공업체(CSP) 중 가장 높게 유지될 것이며, 2026년 연간 40% 이상 성장할 것으로 예측합니다.

이는 AI 인프라 공급 체인의 수직 통합(vertical integration)으로 이어지고 있습니다. 하드웨어-소프트웨어-클라우드를 하나로 묶어 관리함으로써 구글은 비용 절감, 최적화된 AI 성능, 그리고 데이터 보안 측면에서 경쟁 우위를 확보할 수 있습니다. 구글은 2025년 3분기 클라우드 매출이 151억 5,000만 달러로 전년 동기 대비 34% 증가했다고 발표했습니다. Azure는 40% 성장, AWS는 20% 성장을 기록했습니다.

구글은 2025년 첫 9개월 동안 지난 2년을 합친 것보다 더 많은 10억 달러 규모의 클라우드 계약을 체결했다고 밝혔습니다. 급증하는 수요를 충족하기 위해 구글은 올해 자본 지출 상한선을 850억 달러에서 930억 달러로 상향 조정했습니다.

이 같은 변화는 곧 클라우드 기업 간의 경쟁 구도에도 중대한 영향을 미칩니다. AWS는 자체 칩인 Trainium과 Inferentia 시리즈를 강화하고 있고, 마이크로소프트 역시 OpenAI와 협력하여 AI 전용 인프라를 구축 중입니다. 결국 AI 칩 시장은 '엔비디아 독주'에서 '클라우드 3대 기업의 다극 경쟁'으로 이동하는 흐름을 보이게 될 것입니다.

AI 반도체 생태계의 향후 방향

Ironwood의 등장으로 AI 반도체 생태계는 본격적인 '전략적 분화' 단계로 접어들고 있습니다. 모든 기업이 같은 칩을 사용하는 시대는 저물고, 각 클라우드 서비스가 자체 최적화된 AI 칩 아키텍처를 구축하는 방향으로 움직이고 있습니다.

구글은 Ironwood와 함께 새로운 기능들을 발표했습니다. Cluster Director는 조직이 대규모 가속기를 통합된 컴퓨팅 단위로 배포하고 관리할 수 있게 하는 새로운 기능입니다. 이는 여러 랙과 포드에 걸쳐 있는 분산 AI 시스템 관리의 복잡성을 해결합니다. 또한 구글은 Armv9 기반의 첫 범용 프로세서인 Axion을 소개했습니다. Axion은 최대 96개의 vCPU와 최대 768GB의 DDR5 메모리를 지원하며, 현대 x86 CPU 대비 최대 50% 더 높은 성능과 60% 더 높은 에너지 효율을 제공한다고 구글은 밝혔습니다.

IDC 데이터에 따르면 AI Hypercomputer 모델은 기업 고객에게 평균 353%의 3년 ROI, 28% 낮은 IT 지출, 55% 높은 운영 효율성을 제공합니다. 이 변화는 AI 기술 발전의 속도를 가속화시키는 동시에, 산업 내 진입 장벽을 높이는 결과를 낳습니다. 새로운 기업이 AI 인프라 시장에 진입하기 위해선 GPU 구매만으로는 부족하고, 칩 설계·클라우드·모델 최적화 능력까지 모두 확보해야 하기 때문입니다.

앞으로의 시장은 '엔비디아 중심의 하드웨어 생태계'에서 '클라우드 중심의 통합 생태계'로 재편될 가능성이 높습니다. 구글, AWS, 마이크로소프트가 각각 자사 칩을 중심으로 AI 플랫폼을 설계하면서, GPU 시장은 점진적으로 세분화될 것입니다. 이는 AI 개발 비용 절감과 에너지 효율 개선을 이끌어내는 동시에, 더 많은 사용자가 맞춤형 인공지능 환경을 구축할 수 있게 하는 긍정적인 효과를 가져올 것으로 보입니다.

구글의 Ironwood TPU는 신제품이 아닌 AI 반도체 주도권 경쟁의 새로운 국면을 여는 상징적 출발점입니다. 엔비디아의 독주가 이어지던 시장에서 구글의 본격적인 기술적 반격이 시작된 셈입니다. 앞으로는 AI 성능뿐 아니라 생태계 통합력, 에너지 효율, 서비스 확장성이 기업의 핵심 경쟁 요소로 자리잡게 될 것입니다. AI 시대의 중심축이 어디로 이동할지, 지금은 구글의 행보를 눈여겨볼 때입니다.

'Tech로 해석하는 경제 Trend' 카테고리의 다른 글

| 기술협상, 중국-네덜란드 긴장 속 반도체 수출 재개로 정상화 (0) | 2025.11.09 |

|---|---|

| AI 펀드로 돈이 몰리는 글로벌 시장 자금의 재편 이유 (0) | 2025.11.08 |

| 버크셔도 경고하는 AI 기술의 어두운 면 단면, 대응 방안은? (0) | 2025.11.08 |

| 산학협력 기반 반도체 설계 교육, 글로벌 경쟁력의 출발점 (0) | 2025.11.07 |

| HBM 생산 집중이 불러온 메모리 산업의 구조적 불균형 (0) | 2025.11.07 |